新智元报道 编辑:桃子 【新智元导读】谷歌团队推出「通用视觉编码器」VideoPrism,在3600万高质量视频字幕对和5.82亿个视频剪辑的数据集上完成了训练,性能刷新30项SOTA。 AI视频模型Sora爆火之后,Meta、谷歌等大厂纷纷下场做研究,追赶OpenAI的步伐。 最近,来自谷歌团队的研究人员提出了一种通用视频编码器——VideoPrism。 它能够通过单一冻结模型,处理各种视频理解任务。

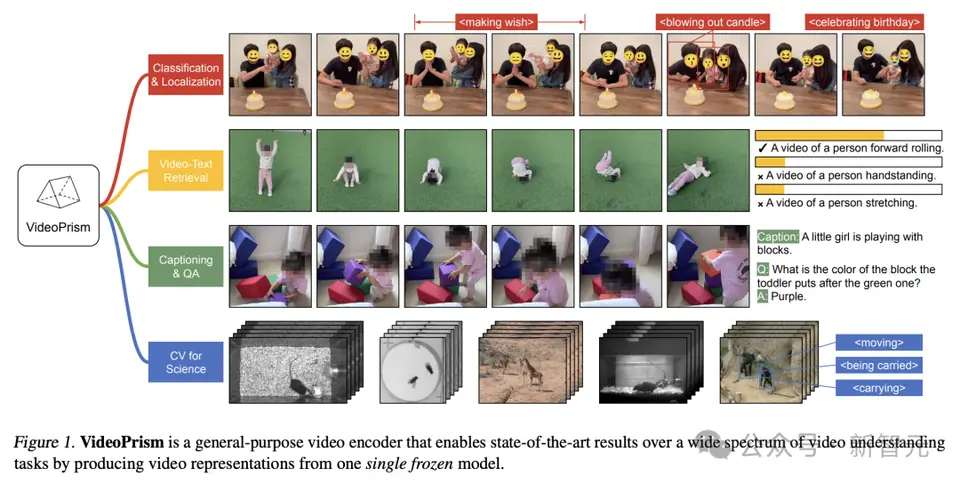

比如,VideoPrism能够将下面视频中吹蜡烛的人分类、定位出来。

视频-文本检索,根据文本内容,可以检索出视频中相应的内容。

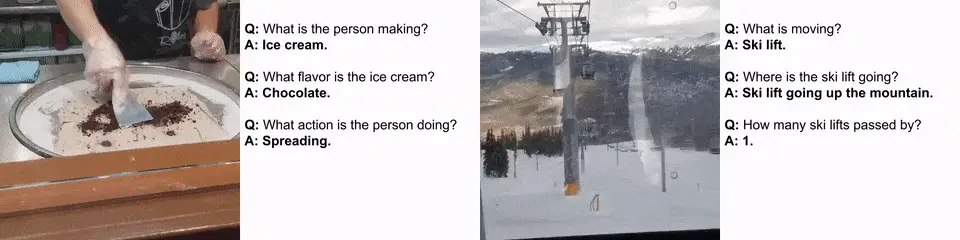

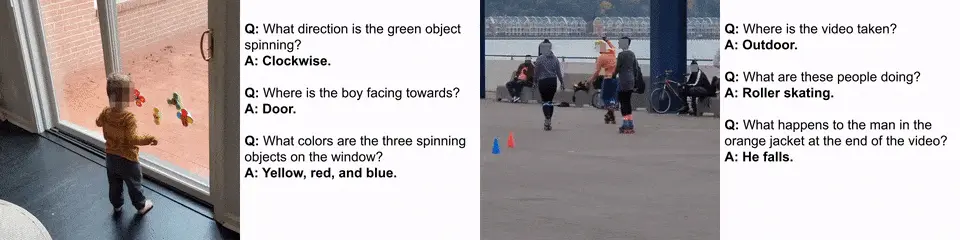

再比如,描述下面视频—— 一个 小女孩正在玩积木 。 还可以进行QA问答。 - 她放在绿色积木块上方积木的是什么颜色? - 紫色 。

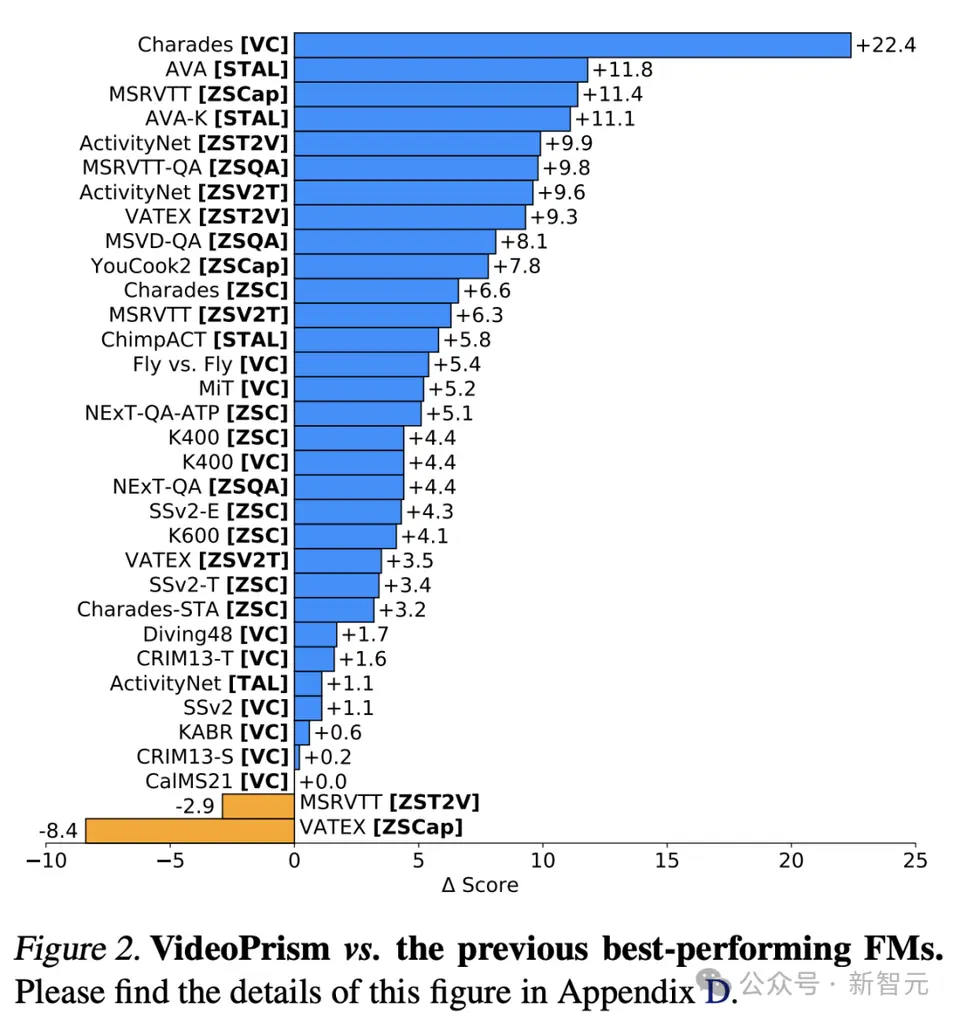

研究人员在一个异构语料库对VideoPrism进行了预训练,包含3600万高质量视频字幕对和5.82亿个视频剪辑,并带有噪声并行文本(如ASR转录文本)。 值得一提的是,VideoPrism在33项视频理解基准测试中,刷新了30项SOTA。

通用视觉编码器VideoPrism 当前,视频基础模型(ViFM)有巨大的潜力,可以在庞大的语料库中解锁新的能力。 虽然之前的研究在一般视频理解方面取得了很大进展,但构建真正的「基础视频模型」仍然是一个难以实现的目标。 对此,谷歌推出了一种通用视觉编码器——VideoPrism,旨在解决广泛的视频理解任务,包括分类、本地化、检索、字幕和问答(QA)。 VideoPrism对CV数据集,以及神经科学和生态学等科学领域的CV任务进行了广泛评估。 通过使用单一冻结模型,以最小的适应度实现了最先进的性能。 另外,谷歌研究人员称,这种冻结编码器设置同时遵循先前研究,并考虑了其实际实用性,以及高计算和微调视频模型的成本。

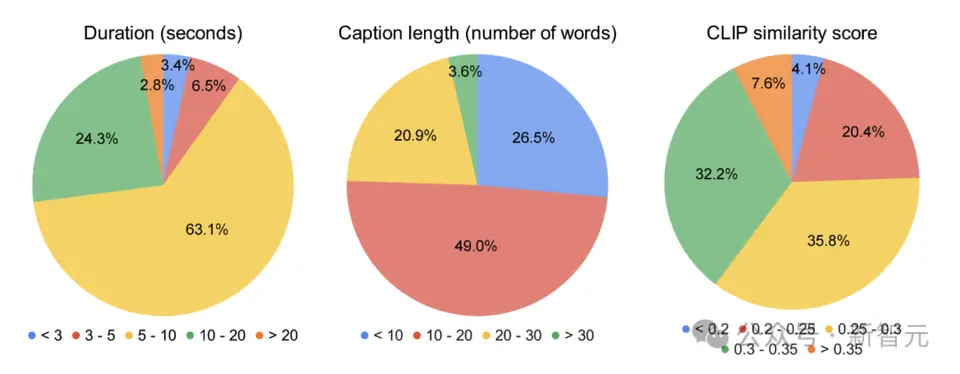

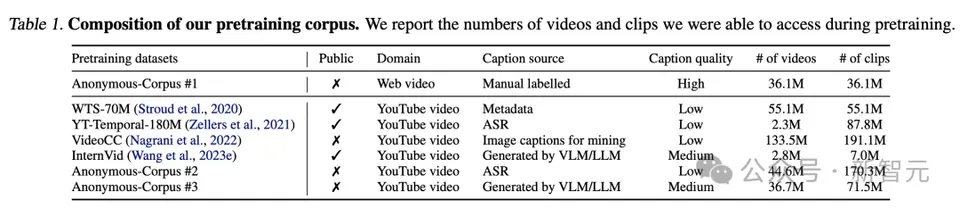

设计架构,两阶段训练法 VideoPrism背后的设计理念如下。 预训练数据是基础模型(FM)的基础,ViFM的理想预训练数据,是世界上所有视频的代表性样本。 这个样本中,大多数视频都没有描述内容的并行文本。 然而,如果训在这样的文本,它就能提供有关视频空间的无价语义线索。 因此,谷歌的预训练策略应主要关注视频模式,同时充分利用任何可用的视频文本对。 在数据方面,谷歌研究人员通过汇集3600万高质量视频字幕对,以及5.82亿视频剪辑与噪声并行文本(如ASR转录、生成的字幕和检索到的文本)来近似建立所需的预训练语料库。

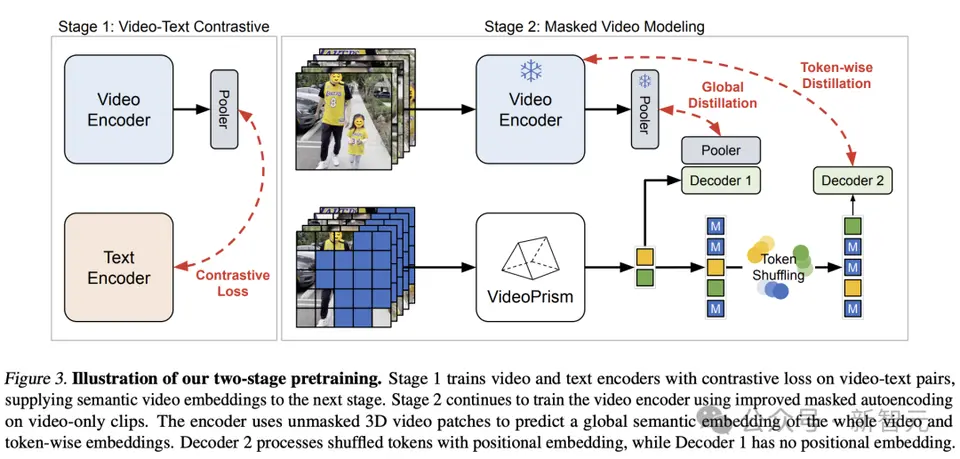

在建模方面,作者首先从所有不同质量的视频-文本对中对比学习语义视频嵌入。 随后,利用广泛的纯视频数据,对语义嵌入进行全局和标记提炼,改进了下文所述的掩码视频建模。 尽管在自然语言方面取得了成功,但由于原始视觉信号缺乏语义,掩码数据建模对于CV来说仍然具有挑战性。 现有研究通过借用间接语义(如使用CLIP引导模型或分词器,或隐含语义来应对这一挑战)或隐性推广它们(比如标记视觉patches),将高掩码率和轻量级解码器结合。 在上述想法的基础上,谷歌团队根据预训练数据采用了两阶段方法。

在第一阶段,进行对比学习,使用所有视频文本对,将视频编码器与文本编码器对齐。 根据先前的研究,谷歌团队最小化批中所有视频文本对的相似性得分,进行对称交叉熵损失最小化。 并使用 CoCa 的图像模型初始化空间编码模块,并将WebLI纳入到预训练中。 在计算损失之前,视频编码器的特征会通过多头注意力汇集池(MAP)进行聚合。 这一阶段允许视频编码器从语言监督中学习丰富的视觉语义,由此产生的模型为第二阶段训练提供语义视频嵌入。

第二阶段,继续训练编码器,并进行了两项改进: - 模型需要根据未掩码的输入视频patches,来预测第一阶段的视频级全局嵌入和token式嵌入 - 编码器的输出token在传给解码器之前,要进行随机洗牌,以避免学习捷径。 值得注意的是,研究人员的预训练利用了两个监督信号:视频的文本描述,以及上下文自监督,使VideoPrism能够在以外观和动作为中心的任务上表现出色。 事实上,之前的研究表明,视频字幕主要揭示外观线索,而上下文我监督有助于学习动作。

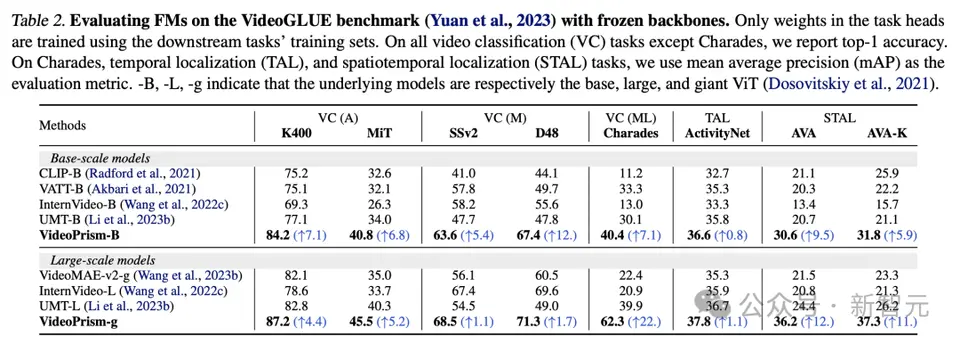

实验结果 接下来,研究人员在广泛的以视频为中心的理解任务上评估VideoPrism,展现其能力和通用性。 主要分为以下四类: (1) 一般仅视频理解,包括分类和时空定位 (2) 零样本视频文本检索 (3) 零样本视频字幕和质量检查 (4) 科学领域的CV任务 分类和时空定位 表2显示了VideoGLUE上的冻结骨干的结果。 在所有数据集上,VideoPrism都大幅优于基线。此外,将VideoPrism的底层模型大小从ViT-B增加到ViT-g可以显着提高性能。 值得注意的是,没有基线方法能在所有基准测试中取得第二好的成绩,这表明以前的方法可能是针对视频理解的某些方面而开发的。 而VideoPrism在这一广泛的任务上持续改进。 这一结果表明,VideoPrism将各种视频信号整合到了一个编码器中:多种粒度的语义、外观与运动线索、时空信息以及对不同视频源(如网络视频与脚本表演)的鲁棒性。

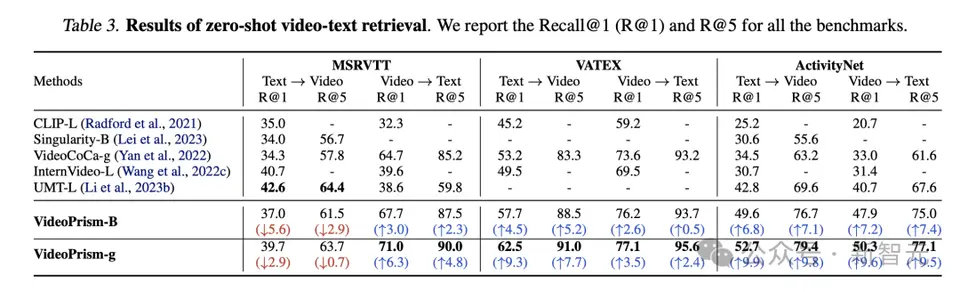

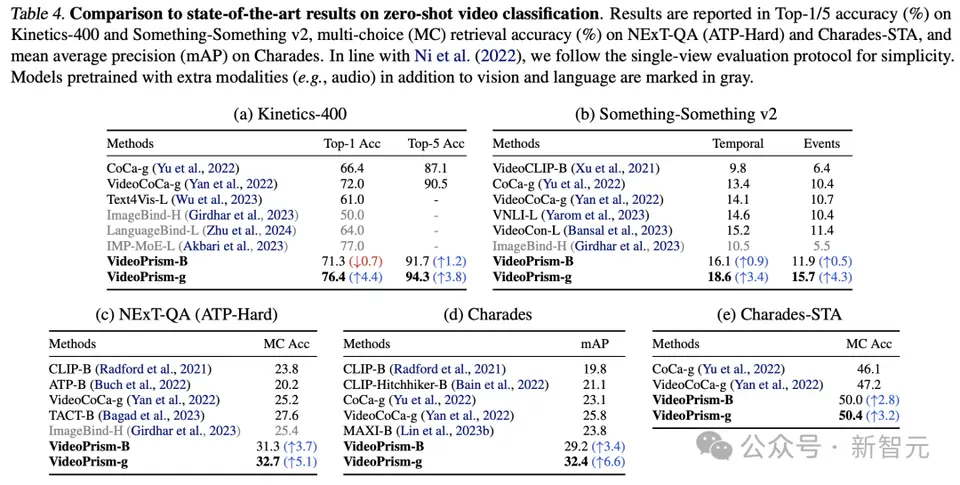

零样本视频文本检索和分类 表3和表4分别总结了视频文本检索和视频分类的结果。 VideoPrism的性能刷新多项基准,而且在具有挑战性的数据集上,VideoPrism 与之前的技术相比取得了非常显著的进步。

基础模型VideoPrism-B 的大多数结果,实际上优于现有的更大规模模型。 此外,VideoPrism与表4中使用域内数据和额外模态(例如音频)预训练的模型相当,甚至更好。这些在零样本检索和分类任务中的改进体现了VideoPrism强大的泛化能力。

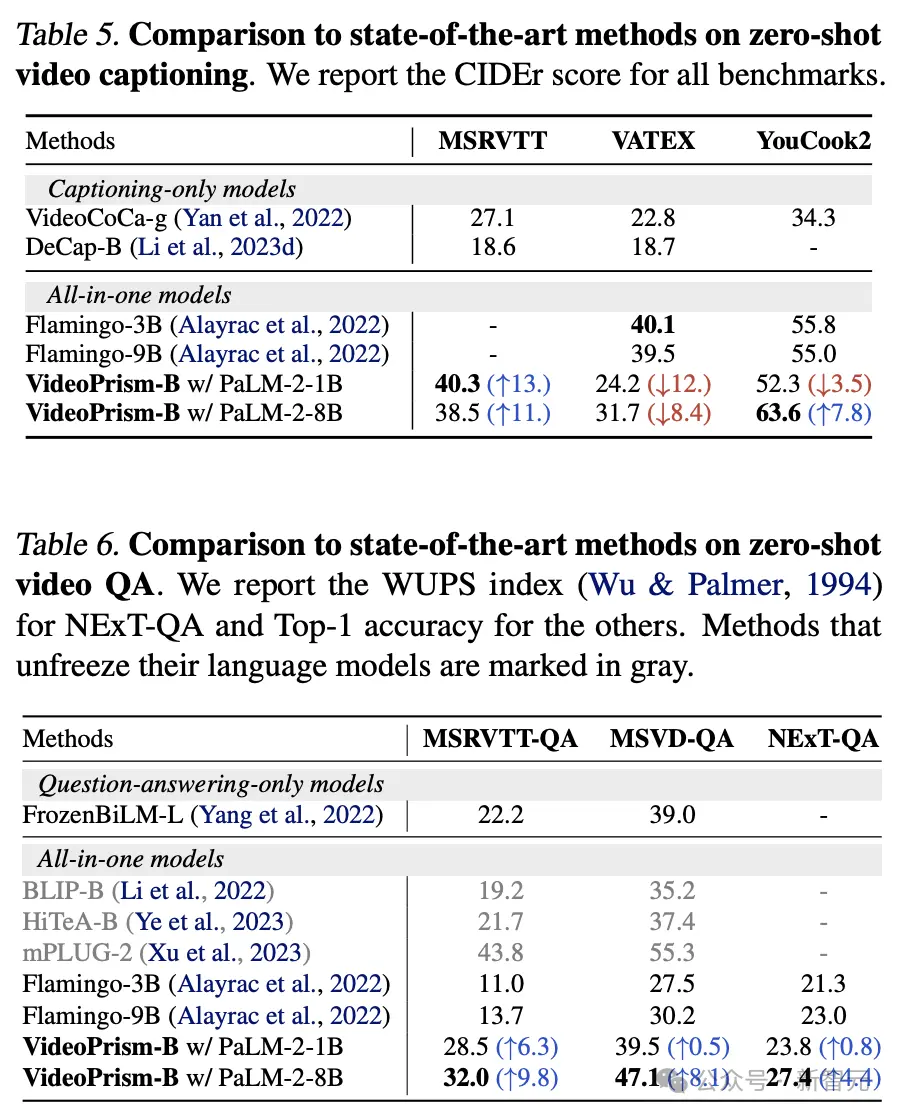

零样本视频字幕和质量检查 表5和表6分别显示了,零样本视频字幕和QA的结果。 尽管模型架构简单且适配器参数数量较少,但最新模型仍具有竞争力,除VATEX外,在冻结视觉和语言模型的方法中名列前茅。 结果表明,VideoPrism编码器能够很好地推广到视频到语言的生成任务。

科学领域的CV任务 通用ViFM在所有评估中使用共享的冻结编码器,其性能与专门用于单个任务的特定领域模型相媲美。 尤其是,VideoPrism通常表现最好,并超越了具有基本规模模型的领域专家模型。 扩展到大规模模型可以进一步提高所有数据集的性能。这些结果表明ViFM有潜力显著加速不同领域的视频分析。

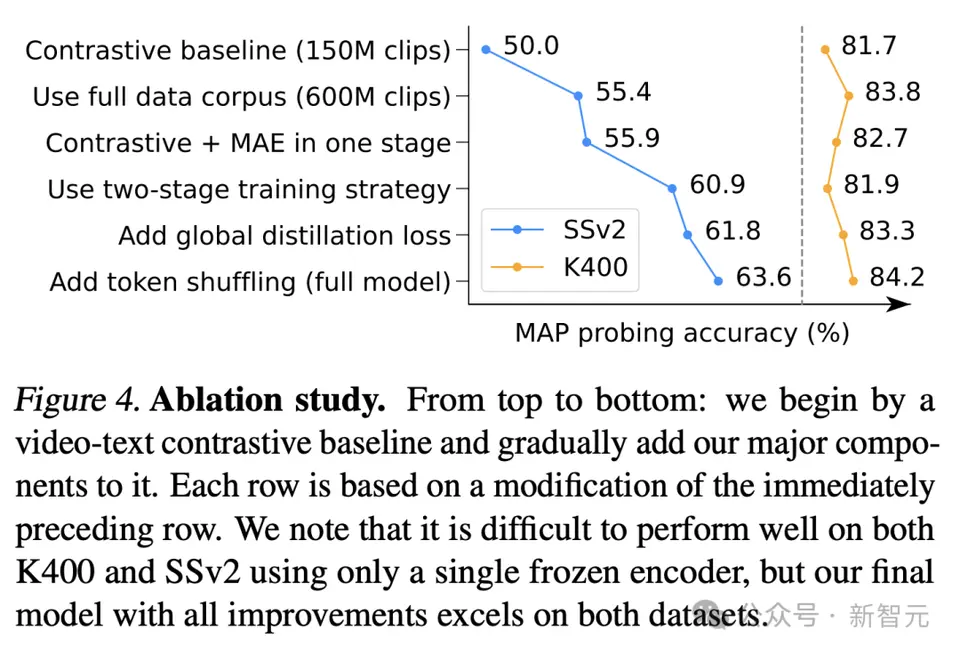

消融研究 图4显示了消融结果。值得注意的是,VideoPrism在SSv2上的持续改进表明,数据管理和模型设计工作在促进视频中的运动理解方面的有效性。 尽管对比基线已经在K400上取得了有竞争力的结果,但所提出的全局蒸馏和token洗牌进一步提高了准确性。

参考资料: https://arxiv.org/pdf/2402.13217.pdf https://blog.research.google/2024/02/videoprism-foundational-visual-encoder.html

|